Mes données sont-elles utilisées par les IA ?

Quand on utilise un assistant IA, que ce soit pour de la prise de décisions, de la rédaction ou pour des tâches du quotidien, on se pose tous la même question : que deviennent les données que je partage ?

Nous voulons tous gagner en productivité grâce à ces outils, sans risquer que nos données sensibles soient exposées.

Pourquoi cette question revient sans cesse ?

Utiliser un assistant IA en réunion, c’est pratique… mais cela signifie aussi confier vos discussions stratégiques à une technologie tierce. Que ce soit pour organiser le travail d’équipe, automatiser certaines tâches ou analyser des informations, les outils d’IA sont partout. Et naturellement, cette présence soulève une question légitime : que deviennent réellement les données que nous partageons ?

En 2024, Meta annonçait vouloir utiliser les contenus partagés par les utilisateurs européens pour entraîner ses IA, sauf opposition explicite. Cette décision a rapidement suscité une vive polémique, notamment portée par l’association NOYB, qui y voyait une possible violation du RGPD. (source : lemonde)

En 2023, le réseau social X (anciennement Twitter) activait par défaut un paramètre autorisant sa filiale xAI à utiliser les publications des utilisateurs pour entraîner son modèle. Beaucoup l’ont découvert après coup, sans information claire au préalable. (Source : lemonde)

Ces exemples montrent à quel point la collecte de données est généralisée, même chez les plus grandes entreprises. Cela rappelle que nous devons toujours rester attentifs à la façon dont nos informations sont utilisées.

Les risques concrets quand les données sont utilisées par l’IA

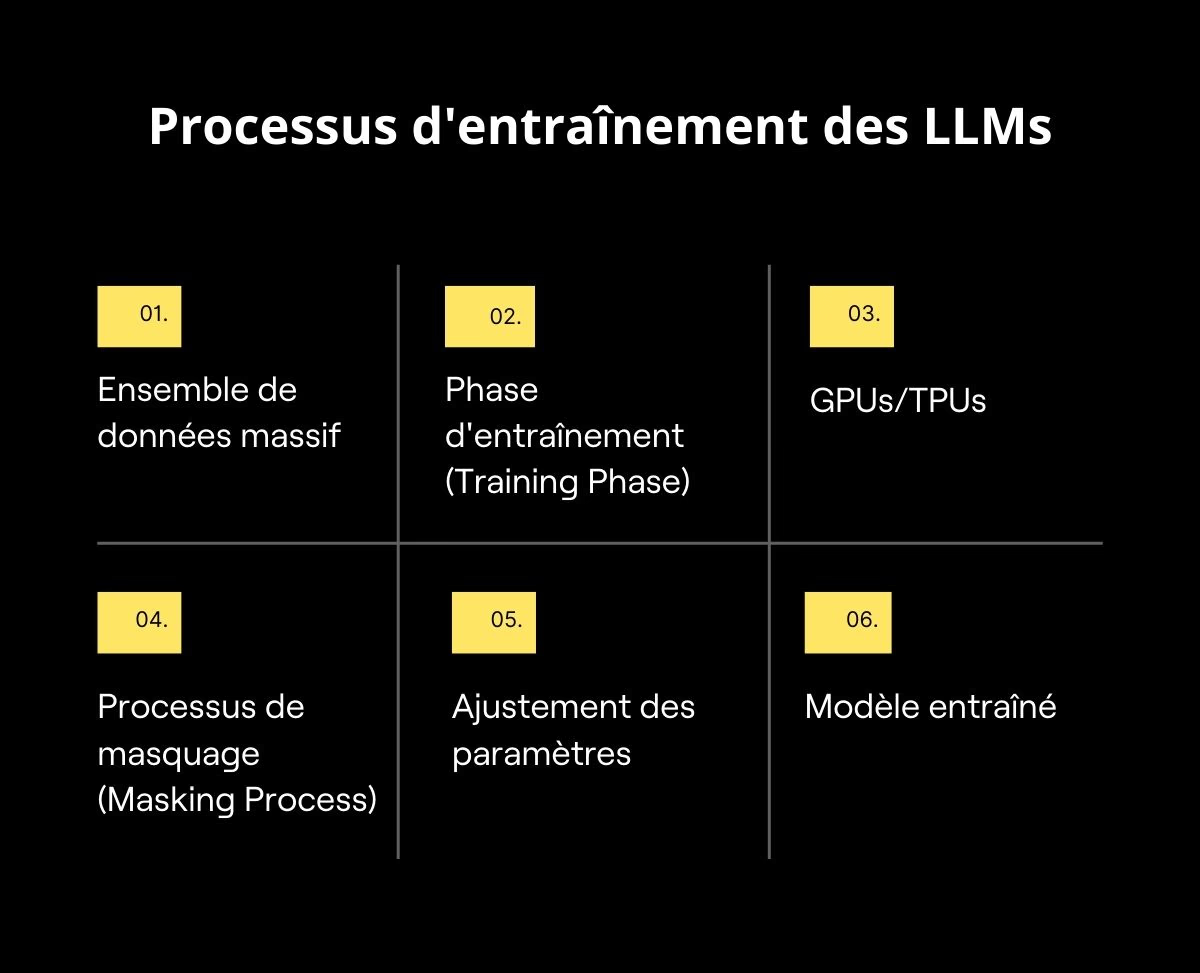

Parler de traitement de données par l’IA n’est pas abstrait : il s’agit de vraies informations, souvent sensibles, qui peuvent être utilisées par des modèles d’intelligence artificielle. Les LLM (Large Language Models), comme ChatGPT (Open AI) ou Mistral AI, fonctionnent en s’entraînant sur des milliards de données pour améliorer leur compréhension et leur performance. Pour innover et rester compétitives, ces entreprises doivent continuer à entraîner leurs modèles en permanence.

Le problème, c’est que des milliers d’utilisateurs fournissent chaque jour des données à ces systèmes parfois sur des modèles qui ne sont pas totalement sécurisés ou dont le stockage n’est pas contrôlé. Sans garanties claires, il peut être difficile de savoir si les informations partagées restent confidentielles ou sont utilisées pour l’entraînement global des modèles.

Face à ces risques et à la multiplication des usages de l’IA entreprise, l’Europe a réagi avec un cadre juridique strict pour protéger les données personnelles et encadrer leur traitement : le RGPD. Ce règlement impose des règles précises sur la collecte, le stockage et l’usage des données, afin de sécuriser la vie privée des utilisateurs et garantir que les informations sensibles ne soient pas exposées.

RGPD et IA : la réglementation qui doit rassurer

Le RGPD (Règlement Général sur la Protection des Données) joue un rôle fondamental pour encadrer l’usage des données personnelles.

Selon la CNIL, toutes les entreprises doivent respecter quelques règles simples lorsqu’elles utilisent vos données :

- Légalité : vos données doivent être utilisées dans un cadre légal.

- Transparence : vous devez savoir quelles informations sont collectées et pourquoi.

- Limiter les données : seules les informations vraiment nécessaires doivent être utilisées.

- Exactitude : les données doivent être correctes et mises à jour si besoin.

- Durée limitée : vos données ne doivent pas être conservées plus longtemps que nécessaire.

- Sécurité : elles doivent être protégées contre toute fuite ou usage non autorisé.

Prenons un exemple : votre entreprise utilise un assistant IA pour automatiser des tâches répétitives. Si l’outil mémorise des informations personnelles de vos collaborateurs ou des décisions stratégiques, le RGPD impose que vous soyez informé de ce stockage et que vous puissiez demander la suppression ou l’anonymisation de ces informations.

Avec ces règles, le RGPD permet aux entreprises de profiter des avantages de l’IA tout en protégeant la confidentialité de leurs équipes et de leurs informations stratégiques.

Pourquoi les entreprises utilisent (ou veulent utiliser) vos données ?

Derrière chaque avancée de l’intelligence artificielle se trouvent… nos données. Chaque interaction, chaque information partagée permet aux outils d’IA entreprise de mieux comprendre, d’apprendre et de s’améliorer.

Concrètement, les entreprises utilisent ces données pour deux objectifs principaux :

- Améliorer la performance de leurs outils : plus un système reçoit d’informations (échanges, documents, interactions d’équipe ) plus il devient précis et efficace. C’est le principe de l’apprentissage automatique : l’outil apprend de ce qu’il voit pour mieux répondre ensuite.

- Personnaliser l’expérience : Un assistant IA bien conçu peut s’adapter aux habitudes d’une équipe, suggérer les points importants, mettre en avant certaines priorités ou ajuster son fonctionnement selon les usages.

Le problème survient lorsque ces informations sont réutilisées pour entraîner des modèles globaux, incorporant les données de plusieurs entreprises ou utilisateurs, sans information claire ou anonymisation stricte. Dans ce cas, les données confidentielles peuvent circuler sans que vous en ayez conscience.

Confidentialité en entreprise : l’enjeu stratégique

Quand il s’agit d’informations sensibles (stratégie, finances, RH), la confidentialité devient un impératif. Vos réunions ne peuvent pas être traitées comme des flux anonymes.

Avec le télétravail, les salariés partagent davantage à travers des visioconférences. Les assistants IA intégrés aux plateformes de réunion récupèrent des données vocales, verbales, contextuelles. Si l’outil n’est pas conçu pour respecter les critères de sécurité et de confidentialité, le risque augmente.

Vers des solutions souveraines et respectueuses

Face à ces défis, plusieurs initiatives émergent pour réconcilier sécurité IA et performance.

Les solutions souveraines, européennes ou françaises, garantissent que les données restent sous législation locale. La France, par exemple, encourage ces architectures pour protéger la confidentialité IA dans le cadre public et privé.

Mistral AI, start-up européenne, propose des modèles d’IA “ouverts”, aussi dits “Open-source”. Ces modèles visent à utiliser l’IA tout en protégeant vos données, en laissant les entreprises héberger et contrôler elles-mêmes les informations au lieu de les envoyer à des serveurs extérieurs.

Chez Delos, l’enjeu est de proposer un assistant IA performant en se basant sur différents modèles (ChatGPT, Mistral, Claude…) tout en protégeant vos données. Elles sont stockées en France, chiffrées et traitées selon les principes du RGPD, ce qui garantit à la fois une sécurité maximale et une opacité totale vis-à-vis des modèles de langage grâce au chiffrement

Conclusion : oui, vos données peuvent être utilisées MAIS vous avez des droits

Alors, finalement : vos données sont-elles utilisées par les IA ? La réponse est “oui”, potentiellement, si vous utilisez un assistant IA ou un outil de transcription sans précautions. Mais dans l’Union européenne, le RGPD IA impose des obligations fortes de transparence, de consentement, de suppression, de minimisation.

Selon une étude de la National Cybersecurity Alliance (NCA) publiée en septembre 2024, près de 40 % des employés déclarent avoir partagé des informations sensibles avec des outils d’IA sans que leur employeur en soit informé. Ces chiffres soulignent l’importance d’intégrer la sécurité et la confidentialité dès la conception des outils d’IA entreprise, et de donner aux utilisateurs un contrôle réel sur leurs données.

Comment choisir le bon assistant IA pour vous ?

- Performance : l’outil doit être efficace et fiable, capable de fournir des résultats précis et pertinents.

- Transparence et contrôle : vous devez savoir ce que fait l’IA avec vos données, comment les supprimer si nécessaire et où elles sont stockées.

- Souveraineté et conformité : privilégiez un outil qui stocke les données en France ou en Europe, respecte le RGPD et n’envoie pas vos informations vers des pays sans protection équivalente.

Si vous souhaitez tester une solution qui allie performance, sécurité et collaboration, n’hésitez pas à essayer la plateforme gratuitement en cliquant sur ce lien : Testez Delos gratuitement.

Prêt à démarrer

avec Delos ?

Commencez dès maintenant avec 1000 crédits offerts

ou demandez un accompagnement personnalisé.

.png)

.jpeg)